De impact van AI op de CO₂-uitstoot

AI voelt vaak gewichtloos, maar achter elk prompt draait een netwerk van servers dat energie verbruikt en dus CO₂ uitstoot. Hoe groot is die impact eigenlijk? Is het iets om zorgen over te maken? En wat betekent dat voor jou als gebruiker?

Leestijd: 5 minuten

De impact van AI op de CO₂-uitstoot

AI voelt vaak gewichtloos: je typt een vraag in ChatGPT (of ieder ander model), en binnen seconden verschijnt een antwoord. Maar achter dat scherm draait een heel netwerk van servers dat energie verbruikt – en dus CO₂ uitstoot.

Hoe groot is die impact eigenlijk? En wat betekent dat voor jou als gebruiker?

Training vs. gebruik: waar zit de impact?

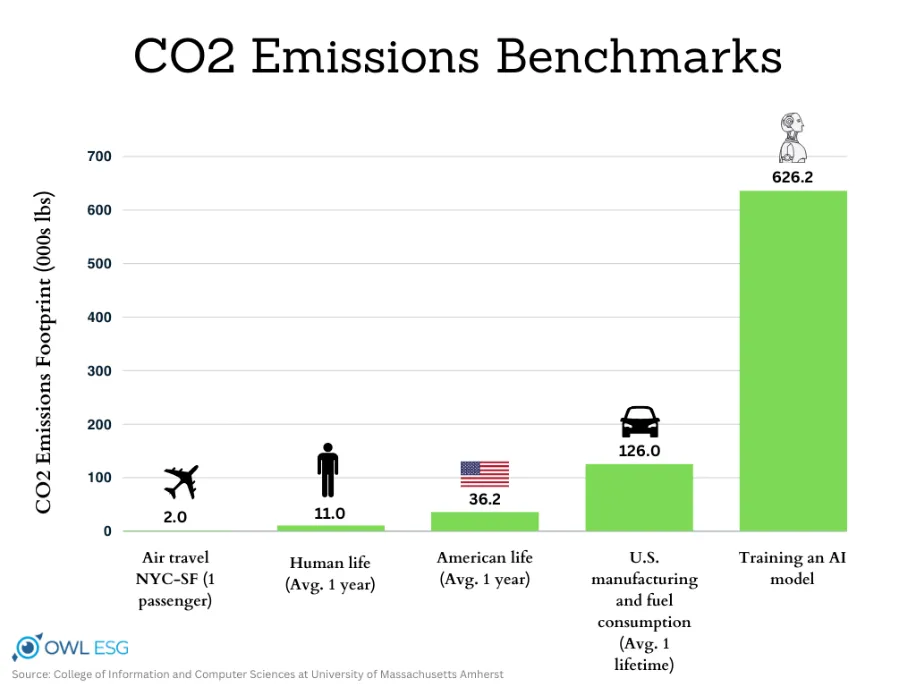

Veel mensen denken dat de grootste uitstoot zit in het trainen van AI-modellen. Dat klopt: de training van GPT-3 zou volgens een studie neer zijn gekomen op honderden tonnen CO₂-equivalent, afhankelijk van de gebruikte stroommix (Carbon Footprint of AI Data Centers).

Maar er is meer: nu miljoenen mensen dagelijks prompts sturen, blijkt dat juist het gebruik (inference) de bulk van de uitstoot kan vormen. Volgens ScienceNews kan dit op termijn zelfs belangrijker worden dan de training zelf.

Eén prompt: hoeveel CO₂ kost dat?

Een recente analyse How Hungry is AI? schat dat een enkele korte GPT-4-prompt ongeveer 0,43 Wh aan stroom verbruikt. Omgerekend betekent dit zo’n 0,17 gram CO₂ per prompt bij een gemiddelde Europese stroommix.

Dat klinkt weinig. Maar wordt dat concreet?

Vergelijken maakt het tastbaar

- 🚗 Autorit: 1 km rijden stoot ~150 g CO₂ uit. Dat is dus gelijk aan bijna 1000 prompts.

- 📱 Smartphone opladen: een volledige lading kost ~5 Wh, oftewel 2 g CO₂. Dat zijn zo’n 12 prompts.

- ☕ Kopje koffie: gemiddeld 100 g CO₂. Dat staat gelijk aan ruim 500 prompts.

Met andere woorden: jouw individuele prompt weegt niet zwaar. Maar bij miljarden prompts per dag stapelt het zich razendsnel op.

En hoe zit het met ChatGPT-5?

Op dit moment zijn er nog geen peer-reviewed studies die het energieverbruik van ChatGPT-5 in detail hebben gemeten. OpenAI heeft zelf ook nog geen cijfers vrijgegeven.

Wel zijn er eerste analistenrapporten en media-artikelen die schattingen maken. Zo meldde DataCenterDynamics dat één GPT-5-prompt gemiddeld rond de 18 Wh zou kunnen verbruiken, met pieken tot wel 40 Wh. Dat is een stuk hoger dan de ~0,4 Wh die recent gemeten is bij GPT-4-prompts (How Hungry is AI?). Zie ook arxiv.org.

Wat we hier in ieder geval van leren:

- Hoe groter en complexer een model is en daarmee de uitwerking van een opdracht, hoe meer energie het kost.

- Eenvoudige vragen vragen relatief weinig rekenkracht.

- Lange of multimodale prompts zijn veel zwaarder.

Dat maakt duidelijk dat ons gebruikersgedrag ook een rol speelt in de uiteindelijke CO₂-impact.

Kan AI ook helpen CO₂ te reduceren?

Interessant genoeg kan AI, mits slim ingezet, juist bijdragen aan CO₂-reductie.

In een artikel (Can artificial intelligence technology reduce carbon emissions?) tonen onderzoekers aan dat landen of regio’s met meer AI-innovatie gemiddeld lagere CO₂-uitstoot rapporteren. Bijvoorbeeld via analyses van patenten blijkt dat AI-gedreven innovatie vaak leidt tot efficiëntere processen en een lager energieverbruik.

Dat suggereert dat AI niet alleen een probleem kan zijn, maar ook een directe oplossing kan zijn voor de CO₂-reductie.

Wat kun je zelf doen?

- Gebruik AI bewust: bundel vragen in plaats van 10 losse prompts.

- Kies duurzame aanbieders: sommige bedrijven draaien hun datacenters (deels) op groene stroom.

- Realiseer de schaal: één prompt is klein, maar collectief heeft het impact.

Conclusie

AI helpt ons slimmer en efficiënter te werken, maar is niet gratis voor het klimaat. Individueel gaat het om fracties van een gram CO₂, maar wereldwijd is de rekensom groot.

Bewust omgaan met prompts en duurzame keuzes maken bij je tools kan wél verschil maken. En wanneer AI slim wordt ingezet, kan het zelfs een bijdrage leveren aan emissiereductie.

👉 Benieuwd hoe AI ook jouw bedrijf slimmer en duurzamer kan maken? Ontdek meer op onze website.